Eine Grundvoraussetzung für hochentwickelte Fahrerassistenzfunktionen und automatisiertes Fahren ist eine zuverlässige Wahrnehmung der Fahrzeugumgebung und deren präzise Bewertung. Der Automobilzulieferer Continental arbeitet an der nächsten Generation des Umfeldmodells, das eine detailgetreue und nahtlose 360-Grad-Darstellung der gesamten Fahrzeugumgebung liefern soll. Dafür kommen ein hochauflösender 3D-LiDAR-Sensor und ein zentrales Steuergerät zum Einsatz.

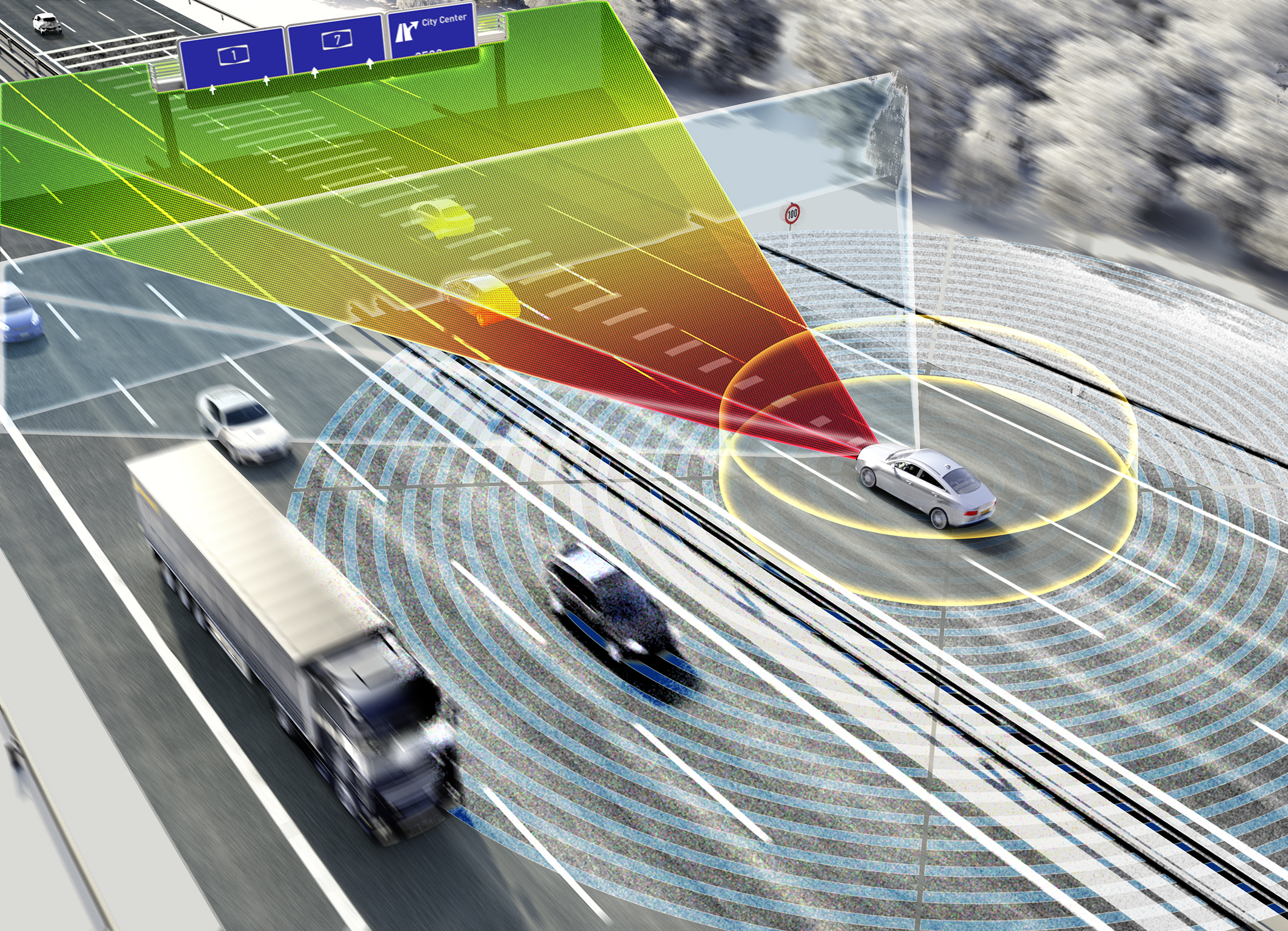

Damit beim automatisierten Fahren die Aufgaben des Fahrers durch das Fahrzeug übernommen werden können, muss dieses nicht nur kontinuierlich Informationen gewinnen, verarbeiten und interpretieren, sondern auch fortlaufend Kontextwissen aufbauen. Nur so lassen sich von einfachen Autobahnsituationen bis hin zu hochkomplexen Verkehrssituationen in Städten immer höhere Stufen des automatisierten Fahrens realisieren. Für ein verlässliches Umfeldmodell werden verschiedene Informationen, wie zu anderen Verkehrsteilnehmern, zu statischen Objekten wie Fahrbahnbegrenzungen, zur eigenen hochgenauen Position und zur Verkehrssteuerung, benötigt. „Um Schritt für Schritt diese Informationen zu sammeln, benötigt man eine Reihe von Sensoren wie Radar, Kamera und Surround View-Systeme. Ziel ist es, ein dem Menschen gleichwertiges oder besseres Verständnis des Fahrzeugumfeldes zu erreichen. Mehr Reichweite, mehr Sensoren sowie die Fusion der gesammelten Daten kombiniert mit hoher Rechenleistung schärft die Sicht und ist der Schlüssel für eine konsistente Sicht auf die Umwelt“, sagte Karl Haupt, Leiter des Geschäftsbereichs Fahrerassistenzsysteme bei Continental.

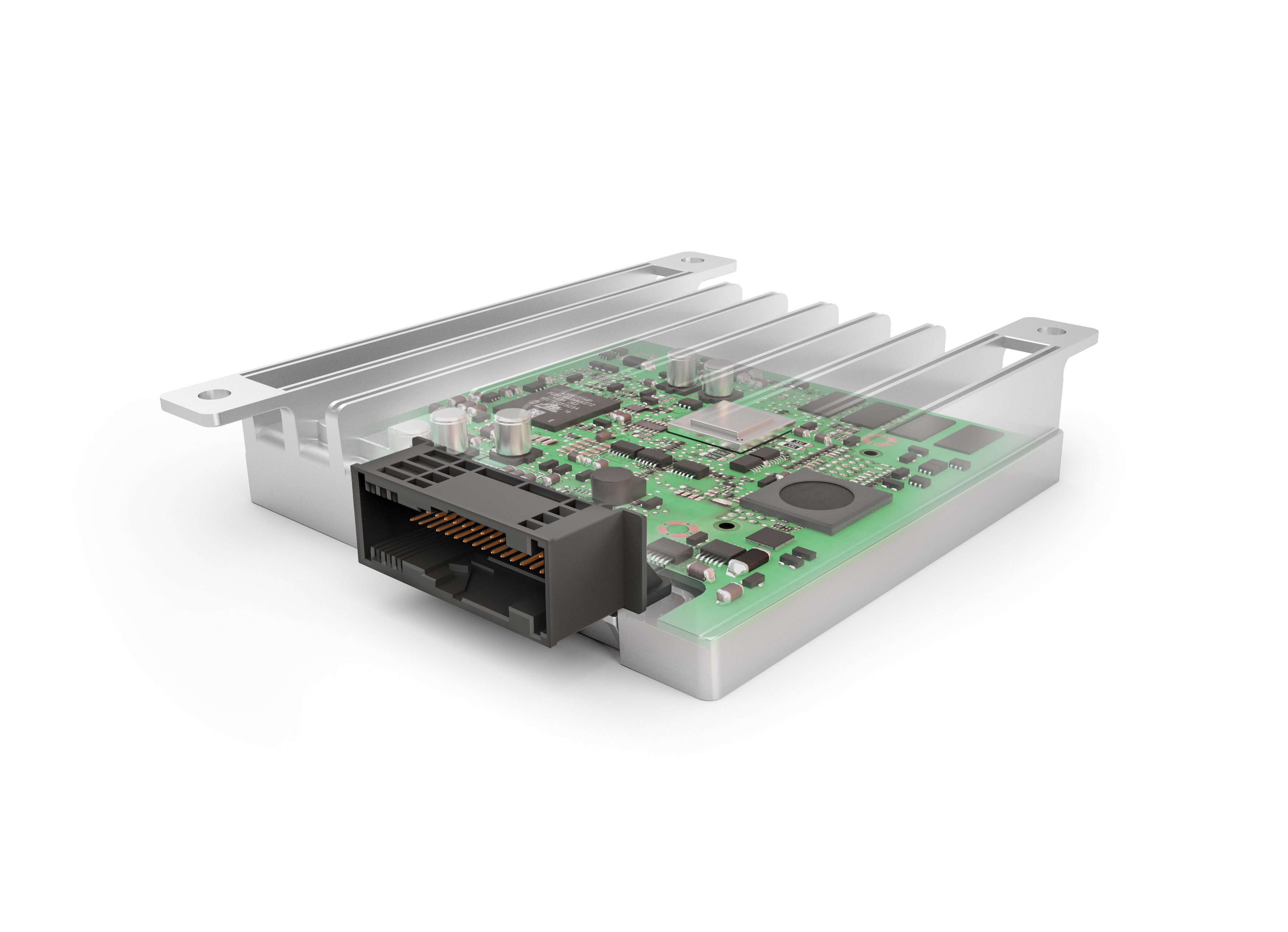

Da jeder Umfeldsensor wie Radar, Kamera und Surround View-Systeme seine physikalisch bedingten Stärken und Schwächen hat, stoßen diese bei manchen Anwendungsfällen an ihre jeweiligen Grenzen. Neben zusätzlichen Informationen, wie zum Beispiel aus dem Backend, werden weitere Sensoren zur Erhöhung der Zuverlässigkeit und Robustheit sowie für weitere Redundanz benötigt. „Wir arbeiten aus diesem Grund an einem High Resolution 3D Flash LIDAR, der den hohen Anforderungen an die Umfelderfassung gerecht wird. Der Sensor bietet eine 3D-Umfelderfassung in Echtzeit und das ohne mechanische Komponenten“, so Haupt weiter. Die Verarbeitung der einzelnen Sensordaten erfolgt entweder im Sensor selbst oder in einem zentralen Steuergerät, welches die unterschiedlichen Daten sammelt, um die Fahrzeugumgebung in einem Umfeldmodell hochgenau abbilden zu können. Je mehr Informationen verarbeitet und analysiert werden müssen, desto mehr Rechenleistung und somit leistungsfähigere Steuergeräte als heute werden für die Erstellung des Umfeldmodells benötigt. Das Umfeldmodell ist dabei als eine Software-Zwischenschicht zwischen den einzelnen Sensoren und den verschiedenen Anwendungen zu verstehen. Diese enthält Datenfusionsalgorithmen zur Erhöhung der Genauigkeit, Zuverlässigkeit und Erweiterung des Sichtbereichs einzelner Sensoren und stellt eine Abstraktionsschicht zu den Funktionen dar. Eine zentrale Stelle für die Auswertung und Interpretation der gesammelten Informationen ist die Assisted & Automated Driving Control Unit von Continental, in der das Umfeldmodell mehr als fünfzigmal pro Sekunde erstellt wird.

Der hochauflösende Umfeldsensor High Resolution 3D Flash LIDAR ist eine Kernkomponente bei der Erstellung des umfassenden 3D-Umfeldmodells. „Die bereits in der Raumfahrt bewährte Technologie ermöglicht ein erheblich umfassenderes und detaillierteres 3D-Bild der gesamten Fahrzeugumgebung sowohl bei Tag als auch bei Nacht und arbeitet auch bei widrigen Wetterbedingungen zuverlässig“, sagte Arnaud Lagandré, Leiter des Segments High Resolution 3D Flash LIDAR bei Continental. Der 3D Flash LIDAR ergänzt das Portfolio an Umfeldsensoren für Fahrerassistenzsysteme von Continental, um im Zusammenspiel mit anderen Sensoren hoch- und vollautomatisiertes Fahren zu realisieren. Der Start der Serienproduktion ist für das Jahr 2020 vorgesehen.

Im Vergleich zu heute oft eingesetzten Scanner-Komponenten besteht der 3D Flash LIDAR aus zwei Schlüsselkomponenten: Einem Pulslaser als Sendequelle, wie der Blitz einer Fotokamera, der die Fahrzeugumgebung in einer Entfernung bis über 200 Metern abtastet, und einem hoch integrierten Empfangschip. Dieser ist ähnlich dem Sensorchip einer Digitalkamera, allerdings mit der Fähigkeit pro Pixel die Pulslaufzeit von mehreren reflektierten Lichtsignalen zu erfassen, die der Entfernung zu Objekten entspricht. Mit dieser einfachen, aber hoch effizienten Methode lässt sich pro Laser-Lichtblitz ein hoch akkurates und verzerrungsfreies Abbild des Umfelds erfassen.

„Ein komplettes 3D-Modell der Fahrzeugumgebung von bis zu über 200 Meter und auf wenige Zentimeter genau wird auf diese Weise innerhalb von 1,32 Mikrosekunden und dreißigmal jede Sekunde erstellt. Zudem wird die Entfernung zu einzelnen Objekten genau erkannt“, sagte Lagandré. „Aufgrund der geringen Komplexität und damit guten Industrialisierbarkeit lassen sich effizient mehrere Sensoren rings um das Fahrzeug realisieren, um in Echtzeit komplette 360-Grad-Abbildungen der Umgebung zu erzeugen.“

Um die gesammelten Informationen auszuwerten, zu interpretieren und ein umfassendes Umfeldmodell zu erstellen, kommt die Assisted & Automated Driving Control Unit ins Spiel. Diese ist ein Zentralrechner, der aus einem Verbund von mehreren heterogenen Recheneinheiten besteht. Das Steuergerät kann zudem eine Hauptrolle bei der Vernetzung von elektronischen Fahrwerk- und Sicherheitssystemen übernehmen. Sie erhöht dabei den Funktionsumfang durch Vernetzung bislang isoliert arbeitender Systeme. Durch die zentrale Koordination der Eingriffsentscheidungen harmonieren simultane Eingriffe in verschiedene Systeme optimal miteinander. „Für Continental ist die Assisted & Automated Driving Control Unit ein zentraler Baustein zur Implementierung der notwendigen funktionalen Sicherheitsarchitektur und zugleich Host für zentrale Umfeldbeschreibungen und Fahrfunktionen, die für das automatisierte Fahren benötigt werden“ sagte Michael Zydek, Leiter der Produktgruppe Assisted & Automated Driving Control Unit im Geschäftsbereich Fahrerassistenzsysteme.

Ziel ist es, bis 2019 eine skalierbare Produktfamilie für assistiertes und automatisiertes Fahren mit höchsten Sicherheitsanforderungen (ASIL D) anzubieten. Das Steuergerät wird eine Vielzahl von Anschlüssen für Ethernet und Low Voltage Differential Signaling (LVDS) für den notwendigen Datenfluss zur Verfügung stellen. „Wir unterscheiden bei der Entwicklung in eine Assisted Driving Control Unit und eine Automated Driving Control Unit. Die erste ist ein skalierbarer Steuergerätebaukasten für Fahrerassistenzsysteme, der für jedes Ausstattungspaket eine kostenoptimale Lösung für Sensorik und Steuergerät bietet. Das Steuergerät für automatisiertes Fahren ist ein Hochleistungsrechner, der den Anforderungen des hochautomatisierten Fahrens entspricht und bei dem spezifische Digitalstrukturen für das Umfeldmodell, Rechner für ASIL D sowie Echtzeitperformance im Vordergrund stehen“, so Zydek.

Das Infotainmentsystem von Continental lautet Connect , es liefert die Online-Services und kann mit den Betriebssystemen MirrorLink und Apples CarPlay arbeiten.